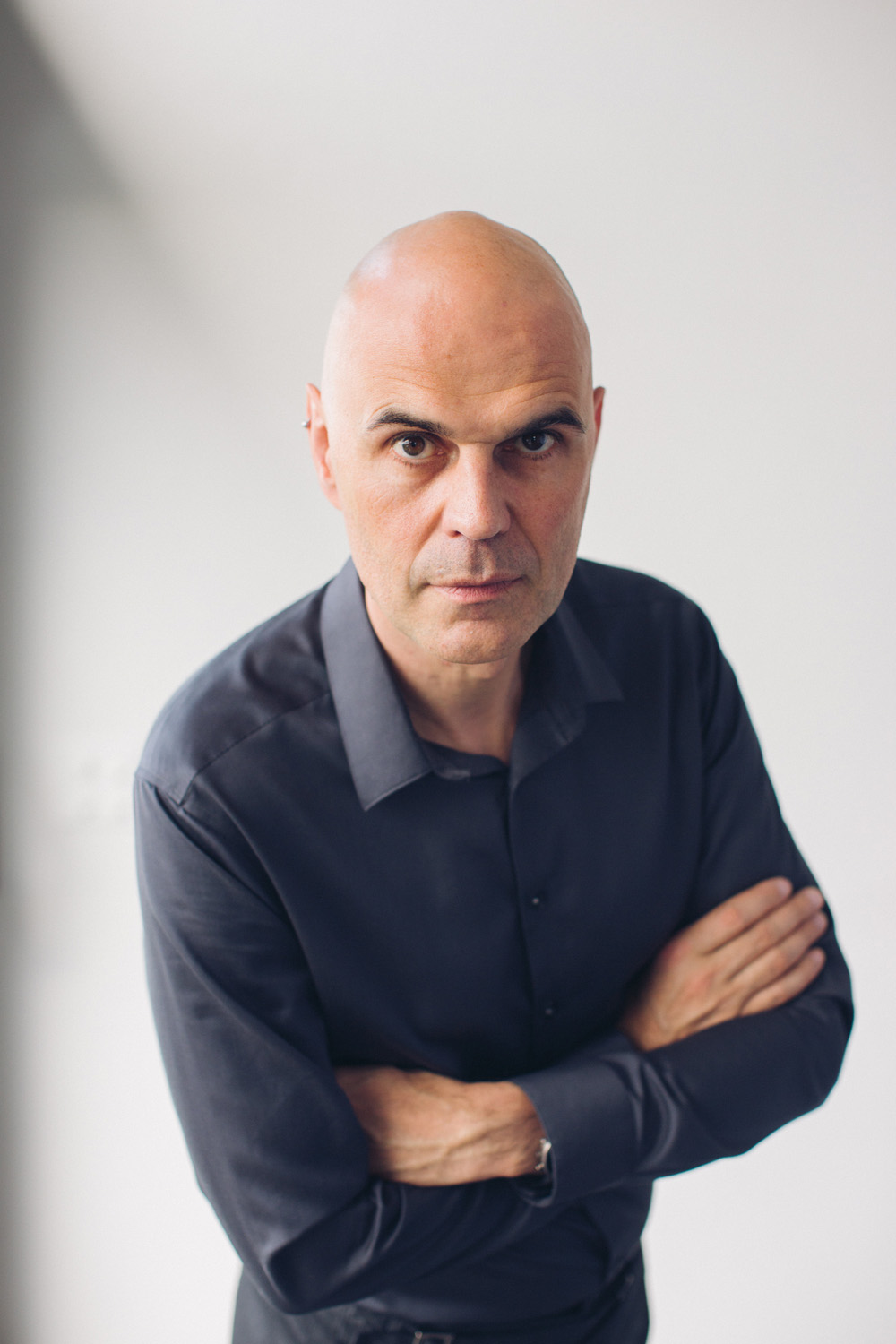

– RTSinfo: A quel stade se trouve-t-on dans le développement d’armes létales autonomes?

Stuart Russell: L’ONU et les Etats-Unis définissent une arme létale autonome comme une arme capable de localiser, sélectionner et attaquer des cibles humaines sans surveillance humaine. Selon cette définition, le missile Harpy/Harop israélien et le robot militaire sentinelle SGR-A1 de Samsung utilisé par la Corée du Sud dans la zone démilitarisée sont déjà des armes létales autonomes.

Si un programme intensif était lancé, des armes autonomes plus puissantes pourraient être produites, par exemple des armes antipersonnel capables de naviguer dans les villes et à l’intérieur des bâtiments. Toutes les technologies nécessaires existent. Construire une arme létale autonome est aujourd’hui plus facile que de construire une voiture autonome.

– Quels avantages les armes autonomes peuvent-elles présenter pour une armée?

– Les partisans des armes autonomes relèvent qu’elles peuvent mener des attaques sans risquer la vie de ses propres soldats, et qu’elles pourraient théoriquement réduire les pertes en éliminant des défenseurs, dans des situations fortifiées, sans recourir à l’artillerie ou aux bombardements.

A noter que cela est aussi vrai pour les drones pilotés à distance, mais les armes autonomes peuvent être beaucoup moins chères que les drones télécommandés, et peuvent être lancées en très grand nombre. Parmi les autres avantages, certains pointent le fait que les armes autonomes pourraient être beaucoup plus efficaces que les pilotes humains dans le combat aérien.

– Quels sont les principaux risques, préoccupations et enjeux liés au développement des armes autonomes?

– En premier lieu, le respect du droit international humanitaire est très important. Faire la distinction entre soldats et civils est possible dans la plupart des cas; en revanche, déterminer la proportionnalité et la nécessité n’est pas faisable pour les systèmes actuels d’intelligence artificielle. Un opérateur humain devrait le faire, ce qui limiterait la portée des missions pouvant être lancées « légalement ». Mais il y a un risque que les armes soient utilisées indistinctement, tout comme des armes chimiques ont pu être utilisées contre des civils en Syrie.

Ensuite, l’autonomie implique qu’un (petit) nombre de personnes ont la capacité de déployer un nombre extrêmement élevé d’armes. En ce sens, les armes autonomes sont des armes de destruction massive – bon marché, efficaces, non attribuables et pouvant proliférer facilement une fois que les grandes puissances initient la production de masse et qu’elles deviennent disponibles sur le marché international des armes.

Avec la capacité de reconnaissance faciale, les armes autonomes offrent la possibilité d’un assassinat à distance et intraçable. Elles permettent par ailleurs l’extension de la cyber-guerre dans le domaine physique, car les systèmes de contrôle logiciel peuvent être infiltrés et modifiés. Par exemple, les armes autonomes d’une nation pourraient être dirigées contre sa propre population civile. Enfin, on ne peut pas écarter la possibilité d’une guerre accidentelle, un « crash éclair » militaire.

– Quels pourraient être, selon vous, des manières moins problématiques de tirer parti de l’intelligence artificielle dans le domaine de la défense?

– Il existe de nombreuses manières moins problématiques d’utiliser l’intelligence artificielle, par exemple pour de la reconnaissance, de la surveillance, l’analyse du renseignement, l’évaluation tactique et stratégique d’une situation, etc…

![]()